Noticias IBL | Nueva York

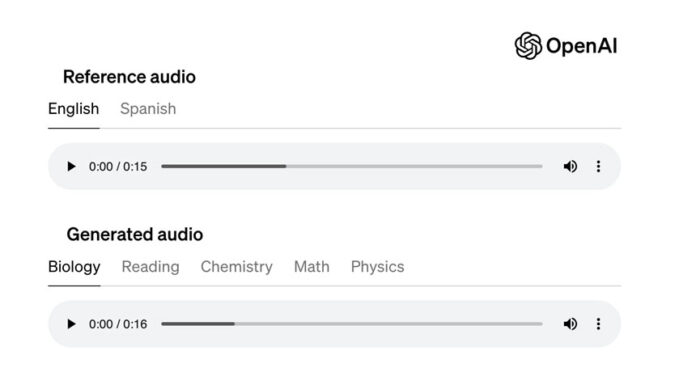

OpenAI reveló que está desarrollando una herramienta que detecta el 98% de las imágenes generadas por su texto -Generador de imágenes del sistema DALL-E 3. El éxito disminuye si se modifican las imágenes.

La herramienta, llamada Media Manager, estará disponible en 2025. Actualmente, la empresa está trabajando con creadores, propietarios de contenido y reguladores para lograr un estándar.

Media Manager parece ser su respuesta a las crecientes críticas al enfoque para desarrollar IA que se basa en gran medida en extraer datos disponibles públicamente de la web.

“Esto requerirá investigación de vanguardia en aprendizaje automático para construir una herramienta única de este tipo que nos ayude a identificar texto, imágenes, audio y video protegidos por derechos de autor en múltiples fuentes y reflejar las preferencias de los creadores”, escribió OpenAI en un publicación de blog.

Recientemente, ocho periódicos estadounidenses, incluido el Chicago Tribune, demandaron a OpenAI por infracción de propiedad intelectual, acusando a OpenAI de robar artículos para entrenar modelos de IA generativa que luego comercializaba sin compensar ni dar crédito a las publicaciones originales.

El año pasado, OpenAI permitió a los artistas optar por no participar y eliminar su trabajo de los conjuntos de datos que la empresa utiliza para entrenar sus modelos de generación de imágenes.

La compañía también permite a los propietarios de sitios web indicar a través del estándar robots.txt, que brinda instrucciones sobre sitios web a los robots de rastreo web. OpenAI continúa firmando acuerdos de licencia con grandes propietarios de contenido, incluidas organizaciones de noticias, bibliotecas de medios de archivo y sitios de preguntas y respuestas como Stack Overflow. Sin embargo, algunos creadores de contenido dicen que OpenAI no ha ido lo suficientemente lejos.

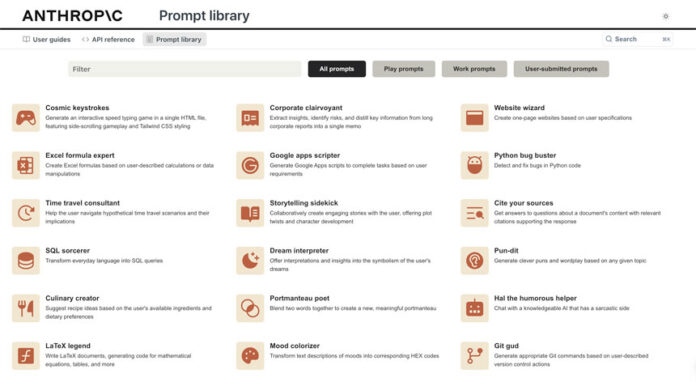

Varios terceros han creado herramientas de exclusión voluntaria para la IA generativa. Startup Spawning AI, cuyos socios incluyen Stability AI y Hugging Face, ofrece una aplicación que identifica y rastrea las direcciones IP de los bots para bloquear los intentos de raspado. Steg.AI e Imatag ayudan a los creadores a establecer la propiedad de sus imágenes mediante la aplicación de marcas de agua imperceptibles para el ojo humano. Nightshade, un proyecto de la Universidad de Chicago, envenena los datos de imágenes para volverlos inútiles o perjudiciales para el entrenamiento del modelo de IA.

.