Noticias IBL | Nueva York

Stability AI, la startup detrás de la herramienta de arte generativo de IA Stable Diffusion, lanzó esta semana un LLM de código abierto con 15 a 65 mil millones de parámetros a seguir.

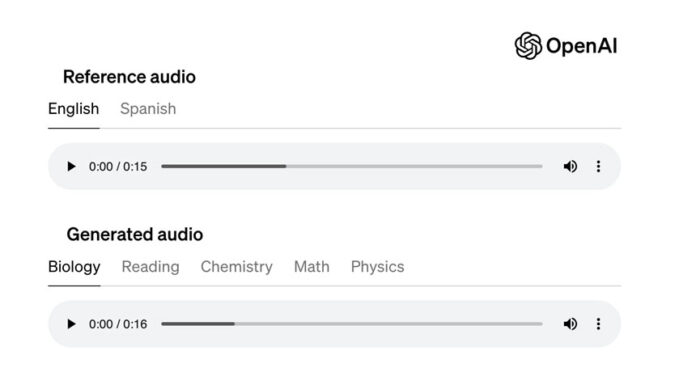

StableLM puede generar texto y código y es una alternativa a OpenAI propietario. “Es un trato enorme, que tiene el potencial de cambiar todo en la IA”, dijo un experto.

Puede ser utilizado con fines comerciales o de investigación, bajo la licencia CC BY-SA-4.0.

Esta versión está disponible en “alfa” en su GitHub y Hugging Spaces, una plataforma para alojar modelos de IA y código.

Se basa en el historial de código abierto de la empresa con EleutherAI, un centro de investigación sin fines de lucro.

En 2022, lanzó el modelo de imagen Stable Diffusion. Las versiones anteriores incluyeron GPT-J, GPT-NeoX y la suite Pythia, que se entrenaron en The Pile conjunto de datos de código abierto: una combinación de muestras de texto extraídas de Internet de sitios web como PubMed, StackExchange y Wikipedia.

Estos modelos de código abierto, incluidos Cerebras- GPT y Dolly-2, podría demostrar que los modelos pequeños y eficientes pueden ofrecer rendimiento con la capacitación adecuada, según los expertos.

StableLM está entrenado en un nuevo conjunto de datos experimentales creado en The Pile, pero tres veces más grande con 1,5 billones de tokens de contenido.

“La riqueza de este conjunto de datos le da a StableLM un rendimiento sorprendentemente alto en tareas de codificación y conversación, a pesar de su pequeño tamaño de 3 a 7 mil millones de parámetros (en comparación, GPT-3 tiene 175 mil millones de parámetros)”, dijo el empresa en una entrada de blog.

Stability también está lanzando un conjunto de modelos de investigación que son instrucción afinada. Usan una combinación de cinco conjuntos de datos recientes, no comerciales, solo de investigación y de código abierto: Alpaca, GPT4All, Dolly, ShareGPT y HH.

“Los modelos lingüísticos formarán la columna vertebral de nuestra economía digital y queremos que todos tengan una voz en su diseño”, dijo Stability AI.

Además, Stability está trabajando en un programa RLHF de colaboración abierta y un conjunto de datos de código abierto para asistentes de IA, Open Assistant.

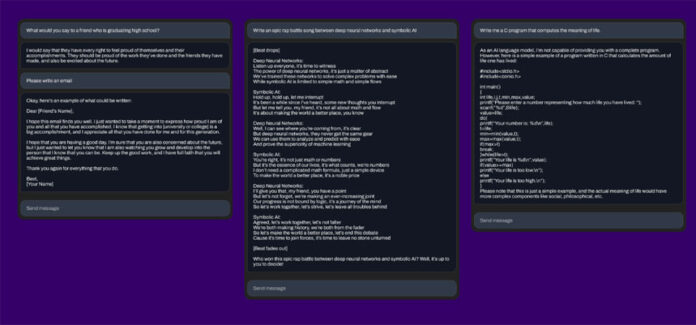

Stability AI no dijo si StableLM alucina e incluye lenguaje y puntos de vista ofensivos. “Dado que The Pile contiene lenguaje profano, lascivo y bastante abrasivo, no sería sorprendente que ese fuera el caso”, escribió TechCrunch.

“Se espera que esto mejore con escala, mejores datos, comentarios de la comunidad y optimización”, respondió Stability.

Se ha demostrado que incluso los modelos comercializados como GPT-4, que tienen filtros y equipos de moderación humanos, arrojan toxicidad.

Algunos investigadores han criticado el lanzamiento de modelos de código abierto, argumentando que podrían usarse para fines desagradables, como crear correos electrónicos de phishing o ayudar a los ataques de malware.

Según Semafor, Stability AI, que recaudó más de $ 100 millones con una valoración de $ 1 mil millones, está bajo presión para monetizar sus esfuerzos. Su director ejecutivo, Emad Mostaque, ha insinuado planes de salida a bolsa.

La empresa se enfrenta a casos legales que alegan que infringió los derechos de millones de artistas al desarrollar herramientas de arte de inteligencia artificial utilizando imágenes con derechos de autor extraídas de la web.

Stability acaba de lanzar su nuevo LLM.

Es de código abierto, tiene 7bparameters y su uso comercial es totalmente gratuito.

Y es un trato ENORME, que tiene el potencial de cambiar todo en AI

He aquí por qué: pic.twitter.com/10CONPz1R8

— Sully (@SullyOmarr) April 20, 2023