Noticias IBL | Nueva York

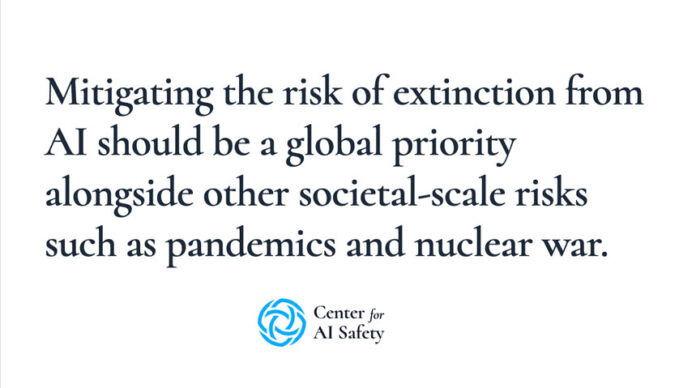

Cientos de científicos, académicos, directores ejecutivos de tecnología y figuras públicas de inteligencia artificial, incluido el director ejecutivo de OpenAI, Sam Altman, y el director ejecutivo de DeepMind, Demis Hassabis, agregaron sus nombres a una declaración de una oración que insta a la atención mundial sobre el riesgo existencial de la IA.

La declaración, alojada en el sitio web de San Francisco- Una organización sin fines de lucro con base en fondos privados llamada Center for AI Safety (CAIS), afirma:

Un breve explicador en el sitio web de CAIS explicó que la declaración se ha mantenido en su mayoría sucinta para superar el obstáculo y abrir la discusión.

“También está destinado a crear conocimiento común del creciente número de expertos y figuras públicas que también toman en serio algunos de los riesgos más graves de la IA avanzada”, declaró el sitio.

En los últimos dos meses, los formuladores de políticas han escuchado las mismas preocupaciones, ya que la exageración de la IA ha surgido debido al acceso ampliado a herramientas de IA generativa como ChatGPT y DALL-E de OpenAI.

En marzo, Elon Musk y muchos otros expertos publicaron una carta abierta en la que pedían una pausa de seis meses en el desarrollo de modelos de IA más potentes que el GPT-4 de OpenAI. Esta pausa permitiría ganar tiempo para diseñar y aplicar protocolos de seguridad compartidos a la IA avanzada