Noticias IBL | Nueva York

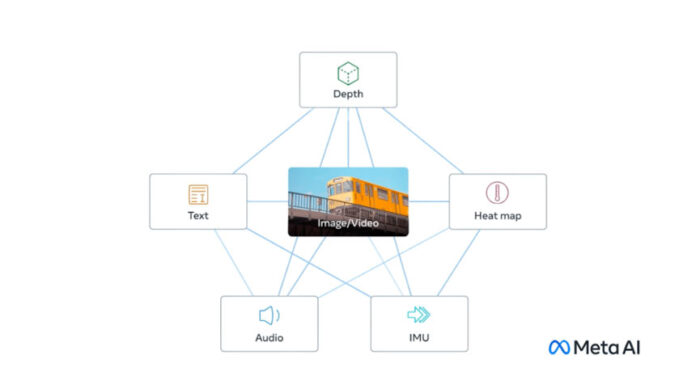

Meta/Facebook anunció un nuevo modelo multisensorial de código abierto que vincula seis tipos de datos (texto, audio, datos visuales, imágenes infrarrojas térmicas y lecturas de movimiento), que apuntan a un futuro de IA generativa que crea experiencias inmersivas al cruzar esta información.

Este modelo es un modelo de investigación, un artículo, sin consumidores inmediatos ni aplicaciones prácticas, y habla a favor de Meta/Facebook ya que OpenAI y Google están desarrollando estos modelos en secreto, según expertos.

Por ejemplo, los generadores de imágenes de IA como DALL-E, Stable Diffusion y Midjourney se basan en sistemas que vinculan texto e imágenes durante la etapa de capacitación, ya que siguen las entradas de texto de los usuarios para generar imágenes. Muchas herramientas de IA generan video o audio de la misma manera.

El modelo subyacente de Meta, llamado ImageBind, es el primero en combinar seis tipos de datos en un único espacio de incrustación .

Recientemente, Meta abrió LLaMA, el modelo de lenguaje que inició un movimiento alternativo a OpenAI y Google. Con ImageBind, continúa con esta estrategia al abrir las compuertas para que los investigadores intenten desarrollar nuevos sistemas de IA holísticos.

• “Cuando los humanos absorben información del mundo, usamos múltiples sentidos de manera innata, como ver una calle concurrida y escuchar los sonidos de los motores de los automóviles. Hoy presentamos un enfoque que lleva a las máquinas un paso más cerca de los humanos”. capacidad de aprender de manera simultánea, holística y directa de muchas formas diferentes de información, sin necesidad de una supervisión explícita (el proceso de organización y etiquetado de datos sin procesar), dijo Meta en una publicación de blog.

• “Por ejemplo, mientras que Make-A-Scene puede generar imágenes usando indicaciones de texto, ImageBind podría actualizarlo para generar imágenes usando sonidos de audio, como risas o lluvia”.

• “Imagínese que alguien pudiera tomar una grabación de video de una puesta de sol en el océano y agregar instantáneamente el clip de audio perfecto para mejorarlo, o cuando un modelo como Make-A-Video produce un video de un carnaval, ImageBind puede sugerir un ruido de fondo para acompañarlo. , creando una experiencia inmersiva”.

• “Todavía queda mucho por descubrir sobre el aprendizaje multimodal. Esperamos que la comunidad de investigación explore ImageBind y el artículo publicado que lo acompaña para encontrar nuevas formas de evaluar los modelos de visión y generar aplicaciones novedosas”.