Noticias IBL | Nueva York

Cuatro días antes del derrocamiento de Sam Altman, varios investigadores escribieron una carta a la junta directiva advirtiendo sobre un poderoso descubrimiento de IA, llamado Proyecto Q*, que, según decían, podría amenazar a la humanidad. Reuters informó ayer al respecto citando como fuentes a dos personas familiarizadas con el asunto.

Esta carta no reportada fue un acontecimiento clave para el despido de Altman, el modelo de la Generación AI que regresaría triunfalmente el martes por la noche.

Esta carta fue un factor entre una lista más larga de quejas de la junta que reflejaba las preocupaciones sobre la comercialización de avances antes de comprender las consecuencias.

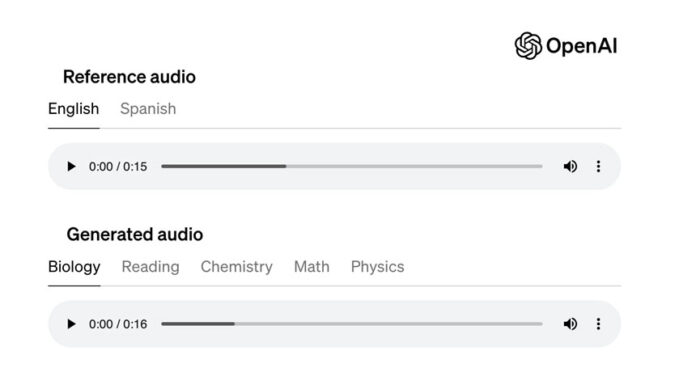

Algunos en OpenAI creen que Q* (pronunciado Q-Star) podría ser un gran avance en la búsqueda de la startup de lo que se conoce como inteligencia artificial general (AGI), dijo una de las personas a Reuters.

OpenAI define AGI como sistemas autónomos que superan a los humanos en la mayoría de las tareas económicamente valiosas.

Los investigadores consideran que las matemáticas son una frontera en el desarrollo de la IA generativa. Actualmente, la IA generativa es buena en escritura y traducción de idiomas al predecir estadísticamente la siguiente palabra, y las respuestas a la misma pregunta pueden variar ampliamente. Pero conquistar la capacidad de hacer matemáticas (donde sólo hay una respuesta correcta) implica que la IA tendría mayores capacidades de razonamiento que se asemejarían a la inteligencia humana. Los investigadores de IA creen que esto podría aplicarse a investigaciones científicas novedosas, por ejemplo.

A diferencia de una calculadora que puede resolver un número limitado de operaciones, AGI puede generalizar, aprender y comprender.

Durante mucho tiempo los científicos informáticos han debatido sobre el peligro que representan las máquinas altamente inteligentes, por ejemplo, si pudieran decidir que la destrucción de la humanidad era de su interés.

Altman ha atraído inversiones y recursos informáticos de Microsoft para acercarse a AGI. Ahora que ha vuelto algunos analistas dicen que puede que tenga menos controles de poder.