Noticias IBL | Nueva York

El enfoque técnico de RAG (Retrieval Augmented Generation) reduce las alucinaciones de los modelos de IA, pero no elimina por completo el problema de las arquitecturas actuales basadas en transformadores, escribe TechCrunch en un artículo.

Sin embargo, varios proveedores de IA generativa sugieren que sus técnicas no producen alucinaciones.

Dado que los modelos de IA generativa no tienen inteligencia real y simplemente predicen palabras, imágenes, habla, música y otros datos, a veces se equivocan y dicen mentiras.

Hasta la fecha, las alucinaciones son un gran problema para las empresas que buscan integrar la tecnología en sus operaciones.

Iniciado por el científico de datos Patrick Lewis, investigador de Meta y University College London, y autor principal del artículo de 2020 que acuñó el término RAG. recupera documentos relevantes para una pregunta usando lo que es esencialmente una búsqueda de palabras clave y luego le pide al modelo que genere respuestas dado este contexto adicional.

Es más efectivo en escenarios “intensivos en conocimiento”, mientras que se vuelve más complicado con tareas “intensivas en razonamiento”, como codificación y matemáticas, ya que es difícil recuperar documentos basados en conceptos abstractos.

RAG también permite a las empresas extraer sus documentos privados de una manera más segura y temporal, evitando que se utilice para entrenar un modelo para permitir modelos.

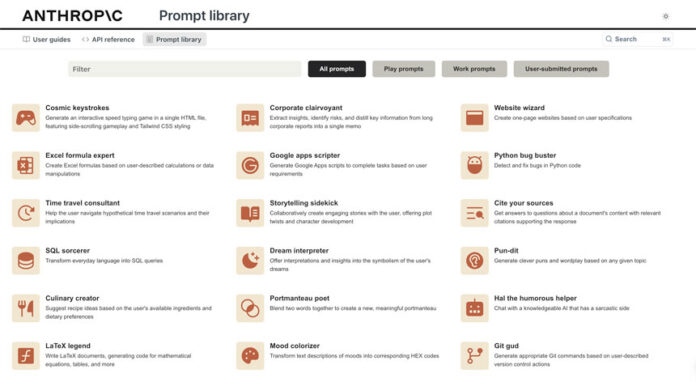

Actualmente, se están realizando muchos esfuerzos para entrenar modelos para hacer un mejor uso de los documentos recuperados por RAG.

.