Noticias IBL | Nueva York

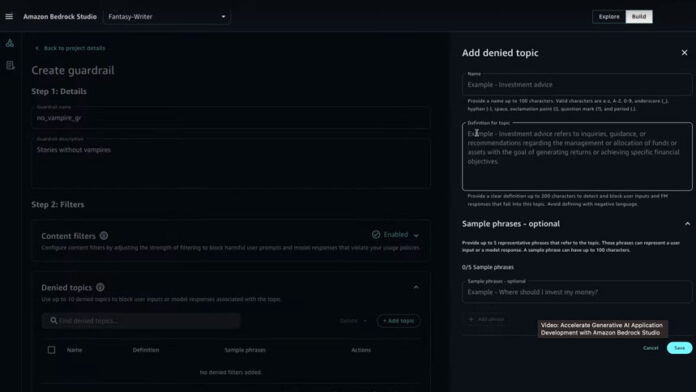

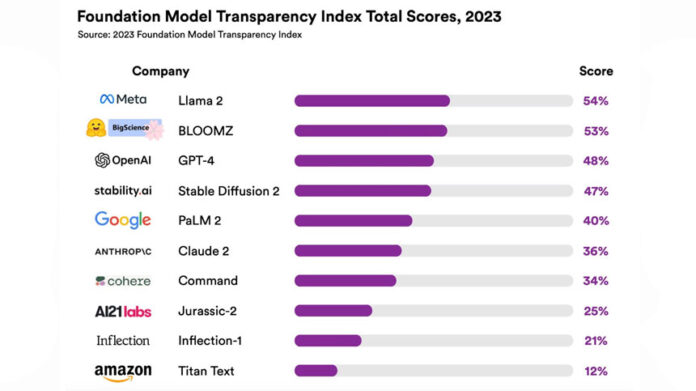

Investigadores de la Universidad de Stanford, el MIT y Princeton clasificaron diez modelos principales de IA en función de su apertura después de aplicar un sistema de puntuación recién creado.

En el índice se incluyen modelos populares como GPT-4 de OpenAI (que impulsa la versión paga de ChatGPT), PaLM 2 de Google (que impulsa a Bard) y LLaMA 2 de Meta. También incluye modelos menos conocidos como Titan Text de Amazon e Inflection AI. Inflexión-1, el modelo que impulsa el chatbot Pi.

Tres sistemas de la lista (Meta, Hugging Face y Stability AI) desarrollan modelos de cimientos abiertos (Llama 2, BLOOMZ y Stable Diffusion 2, respectivamente), y los otros siete desarrolladores crearon modelos de cimientos cerrados accesibles a través de una API.

Llama 2 lideró con un 54%, GPT-4 quedó en tercer lugar con un 48% y PaLM 2 ocupó el quinto lugar con un 40%. Consulte la clasificación en la tabla anterior.

El artículo de investigación del ‘Foundation Model Transparency Index’ de Stanford incluyó 100 indicadores, incluidos los aspectos sociales de los modelos básicos de formación (el impacto en la mano de obra , entorno y política de uso para uso en el mundo real) además de aspectos técnicos (datos, computación y detalles sobre el proceso de capacitación del modelo).

“Los indicadores se basan y sintetizan intervenciones pasadas destinadas a mejorar la transparencia de los sistemas de IA, como tarjetas modelo, hojas de datos, prácticas de evaluación y cómo los modelos básicos intermedian en una cadena de suministro más amplia”, explicó uno de los autores en una publicación de blog.

“La transparencia es escasa en cuestiones relacionadas con cómo se construyen los modelos. En particular, los desarrolladores son opacos sobre qué datos se utilizan para entrenar su modelo, quién proporciona esos datos y cuánto se les paga, y cuánto cálculo se utiliza para entrenar el modelo.”

Los investigadores también publicaron un repositorio con todos sus análisis en nuestro repositorio GitHub.

The New York Times informó que varias empresas de inteligencia artificial ya han sido demandadas por autores, artistas y empresas de medios, acusándolos de utilizar ilegalmente obras protegidas por derechos de autor para entrenar sus modelos.

Hasta ahora, la mayoría de las demandas se han dirigido a proyectos de inteligencia artificial de código abierto o a proyectos que revelaban información detallada sobre sus modelos.