Noticias IBL | Nueva York

Un profesor asistente de la Universidad Furman de Carolina del Sur hizo sonar la alarma sobre el plagio y la deshonestidad académica después de que atraparon a un estudiante que usaba ChatGPT de Open AI para escribir un ensayo para su clase de filosofía.

La tecnología disruptiva de hace tres semanas ChatGPT parece estar provocando trampas a gran escala en el mundo académico.

El profesor asistente de filosofía Darren Hick le dijo a The New York Post, “La academia no vio venir esto. Así que estamos un poco sorprendidos”.

“Tan pronto como informé sobre esto en Facebook, mis amigos académicos dijeron: ‘Sí, yo también atrapé uno’.

Hick explicó este caso de esta manera:

“El estudiante usó ChatGPT, un chatbot avanzado que produce respuestas similares a las humanas a las indicaciones generadas por el usuario. Tales indicaciones pueden variar desde “Explicar el ciclo de Krebs” hasta (como en mi caso) “Escribe 500 palabras sobre Hume y la paradoja del horror”. .”

“Para las clases de primer año, esto es un cambio de juego”.

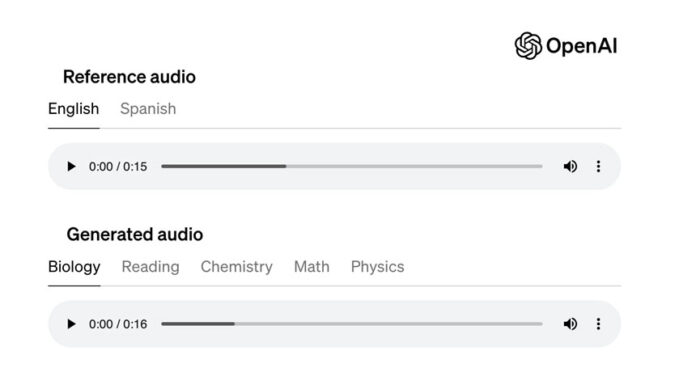

Por ahora, y mientras ChatGPT mejora, una de las soluciones para combatir las trampas es el GPT-2 Output Detector. Detecta si el texto se ha producido con tecnología GPT y determina si es falso. Sin embargo, no puede apuntar a ninguna fuente en Internet ya que utiliza redes neuronales para producir sus respuestas.

“Las administraciones tendrán que desarrollar estándares para tratar este tipo de casos, y tendrán que hacerlo rápido”.

“En el futuro, espero instituir una política que establezca que si creo que el material enviado por un estudiante fue producido por A.I., lo desecharé y le daré al estudiante un examen oral improvisado sobre el mismo material . Hasta que mi escuela desarrolle algún estándar para lidiar con este tipo de cosas, es el único camino que se me ocurre”.