Noticias IBL | Nueva York

Al elegir y organizar un LLM, existen muchos factores técnicos críticos, como datos de capacitación, filtrado de conjuntos de datos, proceso de ajuste, capacidades, latencia, requisitos técnicos y precio.

Los expertos afirman que implementar una API LLM, como GPT-4 u otras, no es la única opción.

Como tecnología que cambia el paradigma y con el ritmo de la innovación avanzando muy rápido, se proyecta que el mercado de los LLM y el procesamiento del lenguaje natural alcanzar 91 mil millones de dólares para 2030 creciendo a una tasa compuesta anual del 27%.

Más allá del recuento de parámetros, hallazgos recientes mostraron que los modelos más pequeños entrenados con más datos son igual de efectivos e incluso pueden generar grandes ganancias en latencia y una reducción significativa de los requisitos de hardware. En otras palabras, lo que importa no es el mayor número de parámetros.

Los datos de entrenamiento deberían incluir conversaciones, juegos y experiencias inmersivas relacionadas con el tema en lugar de crear modelos de propósito general que supieran un poco de todo. Por ejemplo, un modelo cuyos datos de entrenamiento son 90 % de artículos médicos se desempeña mejor en tareas médicas que un modelo mucho más grande donde los artículos médicos solo representan el 10 % de su conjunto de datos.

En términos de filtrado de conjuntos de datos, es necesario eliminar ciertos tipos de contenido para reducir la toxicidad y el sesgo. OpenAI confirmó recientemente que, por ejemplo, se ha filtrado contenido erótico.

También es importante crear vocabularios basados en la frecuencia con la que aparecen las palabras, eliminando conversaciones coloquiales y conjuntos de datos de jerga común.

Los modelos deben ajustarse para garantizar la precisión de la información y evitar información falsa en el conjunto de datos.

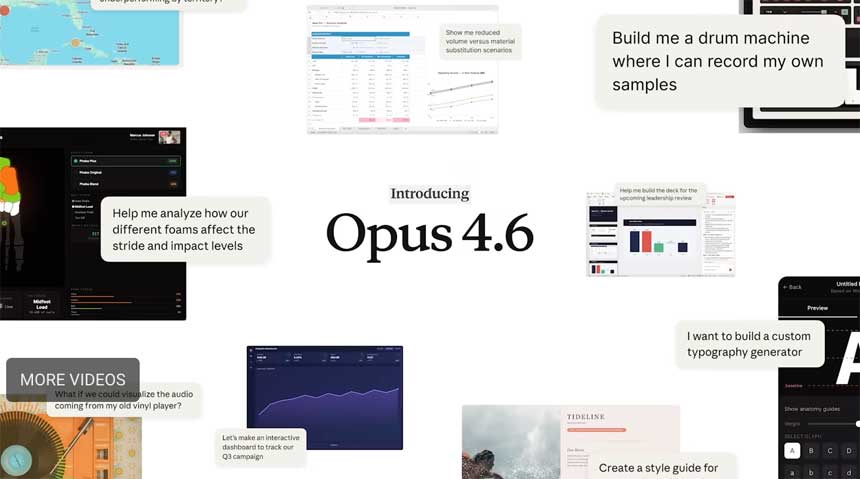

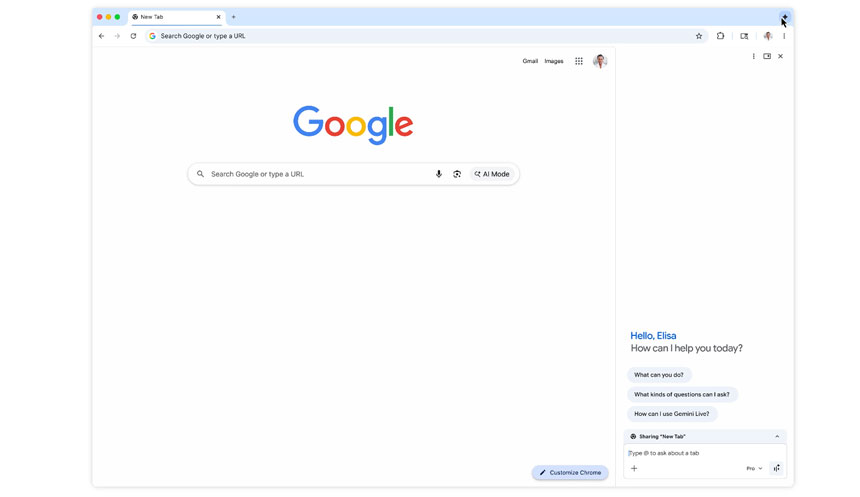

Los LLM no están mercantilizados y algunos modelos tienen capacidades únicas. GPT-4 acepta entradas multimodales como videos y fotos y escribe 25.000 palabras a la vez manteniendo el contexto. PaLM de Google puede generar texto, imágenes, código, vídeos, audio, etc.

Otros modelos pueden proporcionar expresiones faciales y voz.

La latencia de inferencia es mayor en modelos con más parámetros, lo que agrega milisegundos adicionales entre la consulta y la respuesta, lo que afecta significativamente las aplicaciones en tiempo real.

La investigación de Google encontró que sólo medio segundo de latencia adicional hace que el tráfico caiga un 20%.

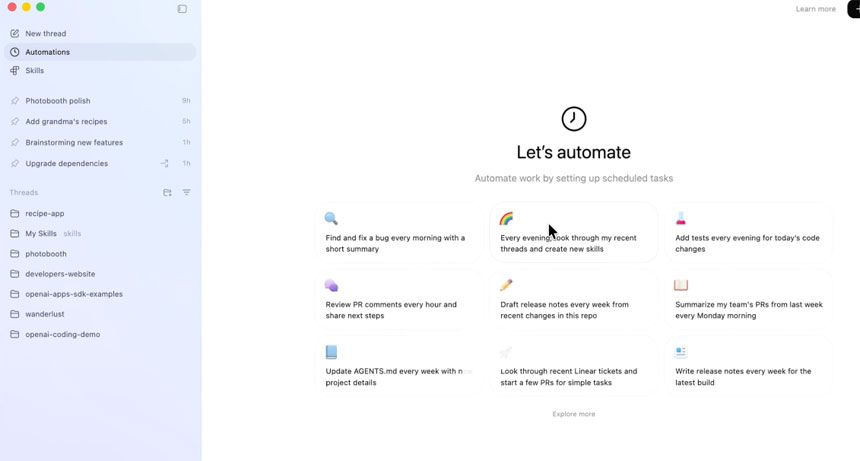

Para una latencia baja o en tiempo real, muchos casos de uso, como la previsión financiera o los videojuegos, no pueden realizarse con un LLM independiente. Se requiere la orquestación de múltiples modelos, funciones especializadas o automatización adicional, para conversión de texto a voz, reconocimiento automático de voz (ASR), visión artificial, memoria, etc.