Noticias IBL | Nueva York

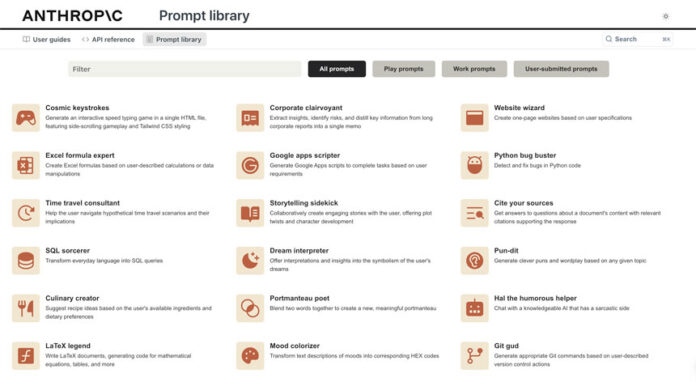

La alucinación en la IA, que ocurre cuando el modelo inventa cosas, es el obstáculo número uno que ven las corporaciones para adoptar LLM (Large Language Models), según compañías como Anthropic, Langchain, Elastics, Dropbox y otras.

Reducir y medir las alucinaciones, junto con la optimización de contextos, la incorporación de multimodalidad y alternativas de GPU, y el aumento de la usabilidad se encuentran entre los diez principales desafíos y las principales direcciones de investigación actuales, experto Chip Huyen escribió en un artículo revelador. Además, muchas empresas emergentes se están centrando en estos problemas.

1. Reducir y medir las alucinaciones

2. Optimice la longitud y la construcción del contexto

3. Incorporar otras modalidades de datos

4. Haga que los LLM sean más rápidos y económicos

5. Diseñar una nueva arquitectura modelo

6. Desarrollar alternativas de GPU

7. Hacer que los agentes sean utilizables

8. Mejorar el aprendizaje a partir de las preferencias humanas

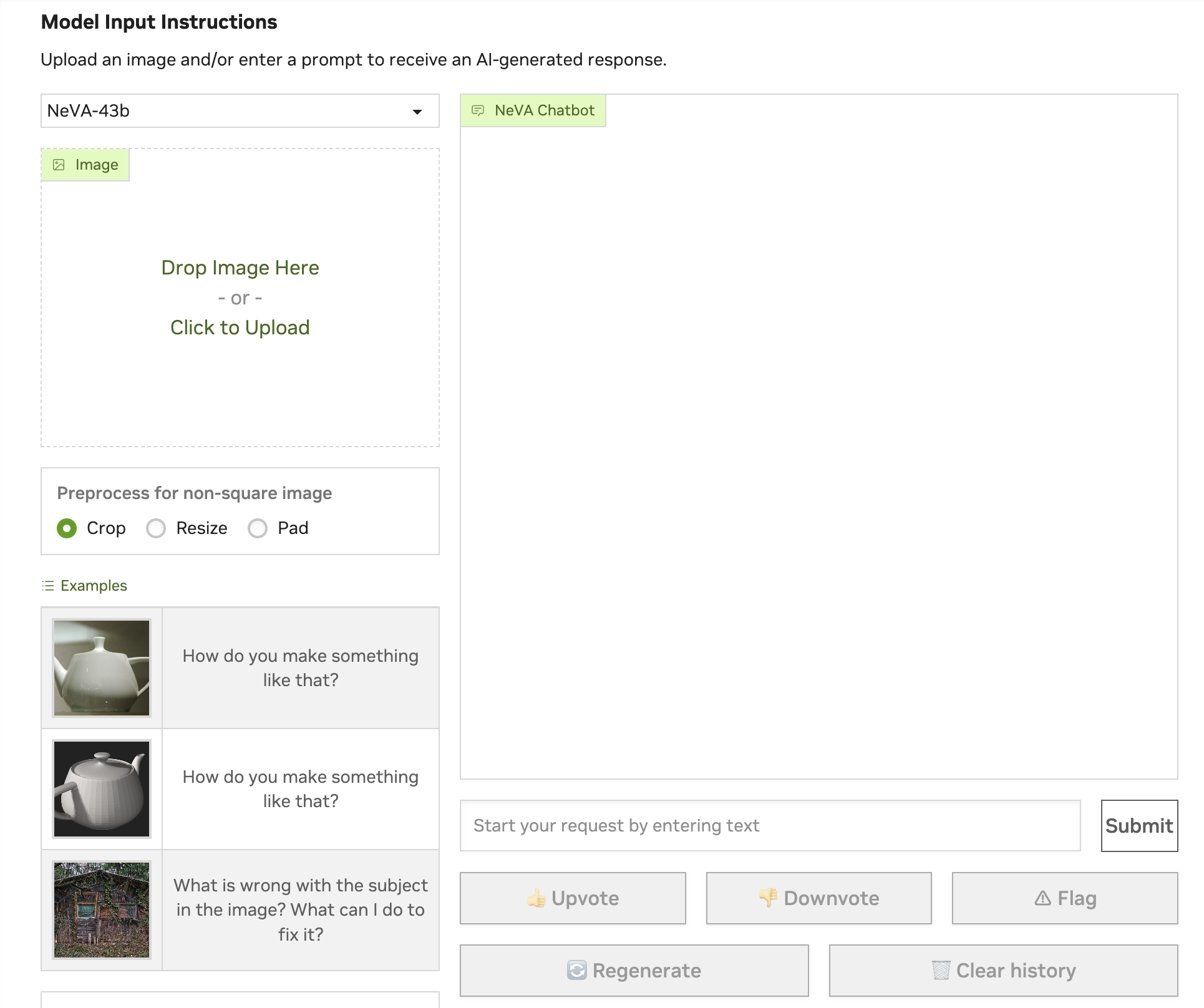

9. Mejorar la eficiencia de la interfaz de chat

10. Cree LLM para idiomas distintos del inglés

• Los consejos ad hoc para reducir las alucinaciones incluyen agregar más contexto a la indicación, una cadena de pensamiento, coherencia personal o pedirle a su modelo que sea conciso en su respuesta.

• El aprendizaje del contexto, la duración y la construcción han surgido como patrones predominantes para la industria LLM, ya que son críticos para RAG – Generación de recuperación aumentada.

• La multimodalidad promete un gran impulso en el rendimiento del modelo.

• Desarrollar una nueva arquitectura para superar a Transformer no es fácil, ya que Transformer ha sido muy optimizado durante los últimos seis años.

• El desarrollo de alternativas de GPU como las computadoras virtuales Quantum sigue atrayendo cientos de millones de dólares.

• Independientemente del entusiasmo en torno a Auto-GPT y GPT-Engineering, todavía hay dudas sobre si los LLM son lo suficientemente confiables y eficaces como para confiarles el poder de actuar.

• La startup más destacada en este ámbito es quizás Adept, que hasta la fecha ha recaudado casi 500 millones de dólares. [Vídeo a continuación]

• DeepMind intenta generar respuestas que agraden a la mayoría de las personas.

• Hay ciertas áreas donde la interfaz de chat se puede mejorar para una mayor eficiencia. El el chatbot NeVA de Nvidia es uno de los ejemplos más mencionados.

• La startup más destacada en este ámbito es quizás Adept, que hasta la fecha ha recaudado casi 500 millones de dólares. [Vídeo a continuación]

• Los LLM actuales que priorizan el inglés no funcionan bien para muchos otros idiomas, tanto en términos de rendimiento, latencia y velocidad. La creación de LLM para idiomas distintos del inglés abre una nueva frontera.

Symato podría ser el mayor esfuerzo comunitario en la actualidad.

.