Noticias IBL | Nueva York

Context.ai, con sede en San Francisco, que desarrolla análisis de productos para aplicaciones impulsadas por LLM (Large Language Models), obtuvo 3,5 millones de dólares en financiación inicial en un ronda codirigida por Google Ventures y Tomasz Tunguz de Theory Ventures.

La inversión se realiza en un momento en que las empresas globales se apresuran a implementar LLM en sus flujos de trabajo y aplicaciones internos. McKinsey estima que las tecnologías de IA generativa pueden aportar hasta 4,4 billones de dólares al año a la economía mundial.

Context.ai proporciona análisis para ayudar a las empresas a comprender las necesidades, comportamientos e interacciones de los usuarios mientras mide y optimiza el rendimiento de los productos habilitados para IA.

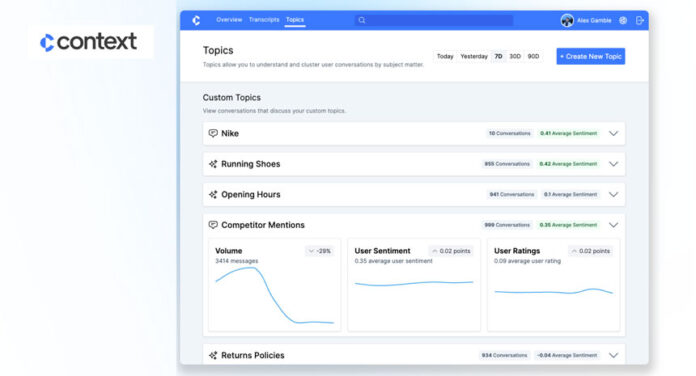

La plataforma Context.ai analiza temas de conversación y monitorea el impacto de los cambios de producto y los riesgos de marca.

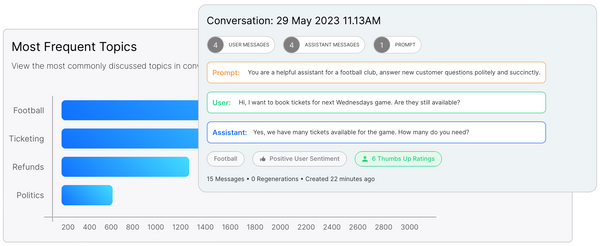

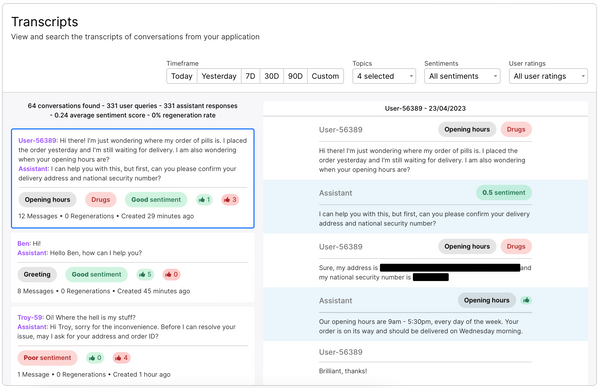

Cubre métricas básicas como el volumen de conversaciones en la aplicación, los temas principales que se discuten, los idiomas más utilizados y las calificaciones de satisfacción del usuario, junto con tareas como el seguimiento de temas específicos, incluidos los riesgosos, y la transcripción de conversaciones completas para ayudar a los equipos a ver cómo funcionan. La aplicación responde en diferentes escenarios.

“Ingerimos transcripciones de mensajes de nuestros clientes a través de API y tenemos SDK y un complemento LangChain que hacen que este proceso demore menos de 30 minutos de trabajo”, dijo Henry Scott-Green, cofundador y director ejecutivo de Context.

“Luego ejecutamos flujos de trabajo de aprendizaje automático sobre las transcripciones ingeridas para comprender las necesidades del usuario final y el rendimiento del producto. Específicamente, esto significa asignar temas a las conversaciones ingeridas, agruparlas automáticamente con conversaciones similares e informar la satisfacción de los usuarios con conversaciones sobre cada tema.”

En última instancia, utilizando los conocimientos de la plataforma, los equipos pueden identificar áreas problemáticas en sus productos LLM y trabajar para abordarlas y ofrecer una oferta mejorada para satisfacer las necesidades de los usuarios.

Según VentureBeat.com, otras soluciones para rastrear el desempeño de LLM incluyen:

• Phoenix, que visualiza complejos Toma de decisiones de LLM y señala cuándo y dónde los modelos fallan, salen mal, dan respuestas deficientes o generalizan incorrectamente.

• model de Datadog, que proporciona capacidades de monitoreo que puede analizar el comportamiento de un modelo y detectar casos de alucinaciones y derivas en función de características de los datos, como longitudes de mensajes y respuestas, latencias de API y recuentos de tokens.

• Empresas de análisis de productos como Amplitud y Mixpanel.

“El ecosistema actual de productos de análisis está diseñado para contar clics. Pero a medida que las empresas agregan funciones impulsadas por LLM, el texto ahora se convierte en un método de interacción principal para sus usuarios”, explica el cofundador y director de tecnología Alex Gamble a Maginative.com.

En cuanto a la privacidad de los datos, Context.ai garantiza la eliminación de la información de identificación personal de los datos que recopila. Sin embargo, la práctica real de profundizar en las conversaciones de los usuarios para realizar análisis es controvertida, ya que los usuarios no suelen dar su consentimiento para analizar los datos.

Demostración contextual del producto de Alex Gamble en Vimeo.

• publicación de blog de Context.ai: Por qué necesita Product Analytics para crear excelentes productos LLM