Noticias IBL | Nueva York

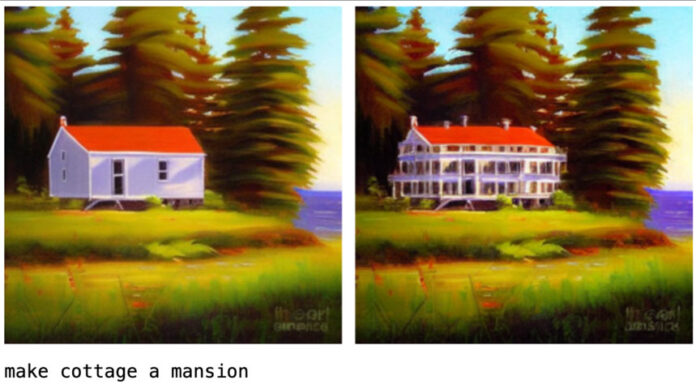

Apple lanzó la semana pasada MGIE (edición de imágenes guiada por MLLM), una nueva herramienta de código abierto. Modelo de IA que edita imágenes basándose en instrucciones en lenguaje natural. Aprovecha los modelos de lenguaje grande multimodal (MLLM) para interpretar comandos de usuario y realizar manipulaciones a nivel de píxeles.

Los expertos coincidieron en que MGIE representa un gran avance y destacaron que el ritmo del progreso en los sistemas de IA multimodal se está acelerando rápidamente.

El modelo puede manejar una amplia gama de escenarios de edición, como ajustes simples de color y brillo, optimización de fotografías, manipulaciones de objetos y modificaciones al estilo de Photoshop, como recortar, cambiar el tamaño, rotar, voltear y agregar filtros.

Por ejemplo, una instrucción puede hacer que el cielo sea más azul y MGIE produce la instrucción para aumentar la saturación de la región del cielo en un 20 %.

MGIE, que fue presentado en un artículo aceptado en la Conferencia Internacional sobre Representaciones del Aprendizaje (ICLR) 2024 — es el resultado de una colaboración entre Apple e investigadores de la Universidad de California, Santa Bárbara.

MGIE está disponible como un proyecto código abierto en GitHub. El proyecto también proporciona un cuaderno de demostración que muestra cómo utilizar MGIE para diversas tareas de edición. Los usuarios también pueden probar MGIE en línea a través de una demostración web alojada en Hugging Face Spaces.

.