IBL News | Nueva York

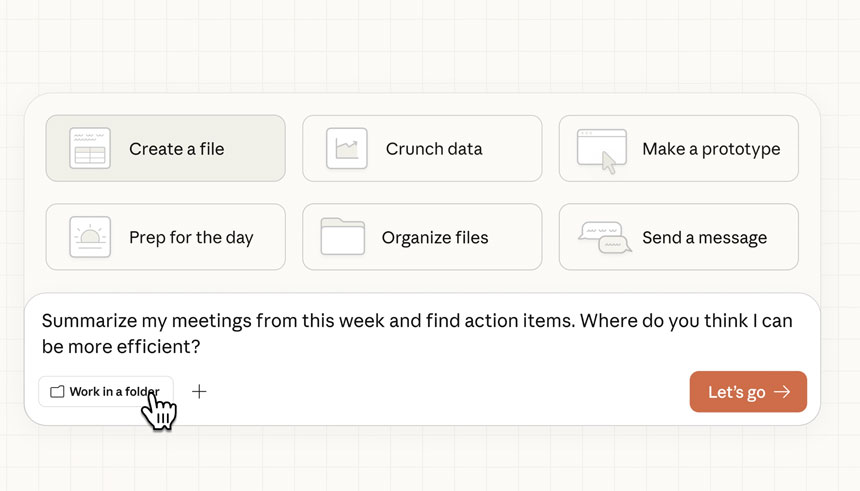

OpenAI planteó preguntas sobre la seguridad de los agentes de IA que operan en la web abierta, específicamente su navegador de IA Atlas.

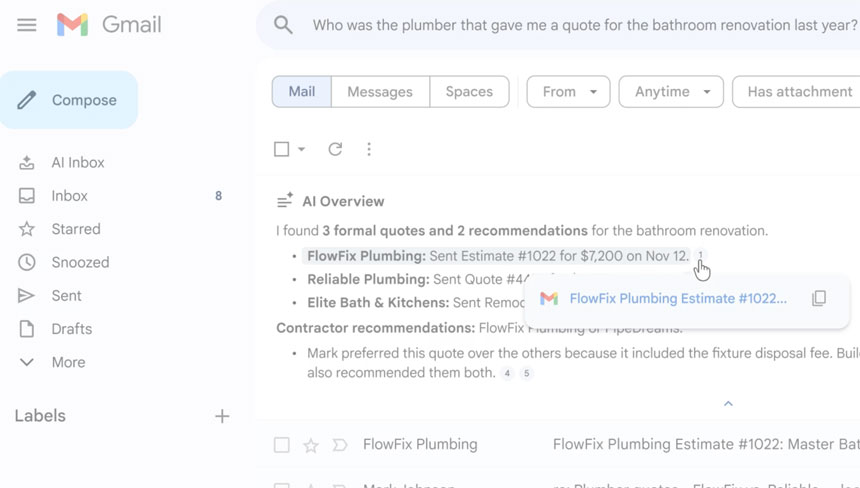

El laboratorio con sede en San Francisco admitió que las inyecciones rápidas, un tipo de ciberataque que manipula a los agentes de IA para seguir instrucciones maliciosas, a menudo están ocultas en páginas web o correos electrónicos.

“La inyección de instrucciones, al igual que las estafas y la ingeniería social en la web, es poco probable que se resuelva por completo”, escribió OpenAI en una publicación de blog del lunes aquí, reconociendo que “el modo agente” en ChatGPT Atlas “amplía la superficie de amenaza de seguridad”.

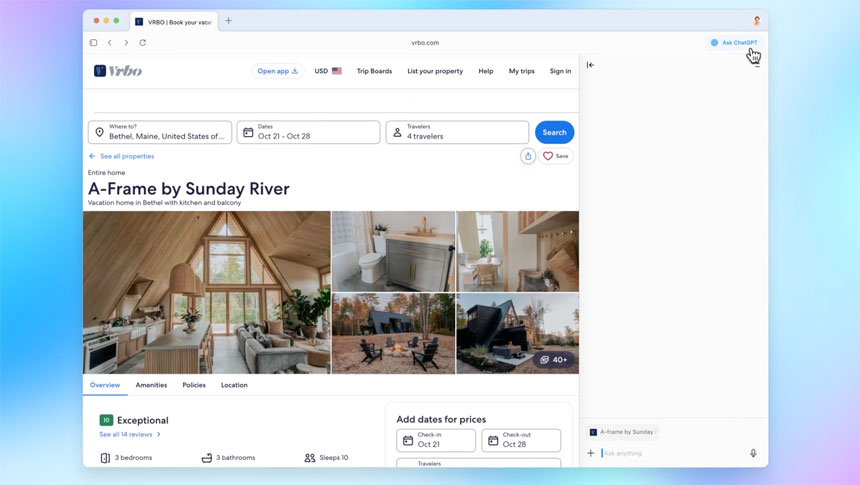

OpenAI lanzó su navegador ChatGPT Atlas en octubre. Los investigadores de seguridad luego demostraron que escribir algunas palabras en Google Docs podría cambiar el comportamiento del navegador.

También en octubre, Brave publicó una publicación en el blog explicando que la inyección de instrucciones indirectas es un desafío sistemático para los navegadores impulsados por IA, incluido Comet de Perplexity.

El Centro Nacional de Ciberseguridad del Reino Unido advirtió a principios de este mes que los ataques de inyección de instrucciones contra aplicaciones de IA generativa “nunca se mitigarán por completo”, poniendo en riesgo a los sitios web de sufrir brechas de datos.

En una demostración, OpenAI mostró cómo su atacante automatizado deslizó un correo electrónico malicioso en la bandeja de entrada de un usuario, enviando un mensaje de renuncia en lugar de redactar una respuesta automática fuera de la oficina.