IBL News | Nueva York

IBM lanzó la semana pasada, bajo la licencia Apache 2.0, cuatro nuevos modelos Granite 4.0 Nano, diseñados para ser altamente accesibles y adecuados para desarrolladores que crean aplicaciones en hardware de consumo, sin depender de la computación en la nube.

Con estos modelos, IBM está ingresando a un mercado abarrotado y en rápida evolución de modelos de lenguaje pequeños (SLMs), compitiendo con ofertas como Qwen3, Gemma de Google, LFM2 de LiquidAI y los modelos densos de Mistral en el espacio de parámetros sub-2B.

Con este lanzamiento, IBM está posicionando Granite como una plataforma para construir la próxima generación de sistemas de IA livianos y confiables.

Las variantes de 350M pueden ejecutarse cómodamente en una CPU de computadora portátil moderna con 8-16GB de RAM, mientras que los modelos de 1.5B típicamente requieren una GPU con al menos 6-8GB de VRAM para un rendimiento óptimo.

Esto es una fracción del tamaño de sus contrapartes vinculadas a servidores de empresas como OpenAI, Anthropic y Google.

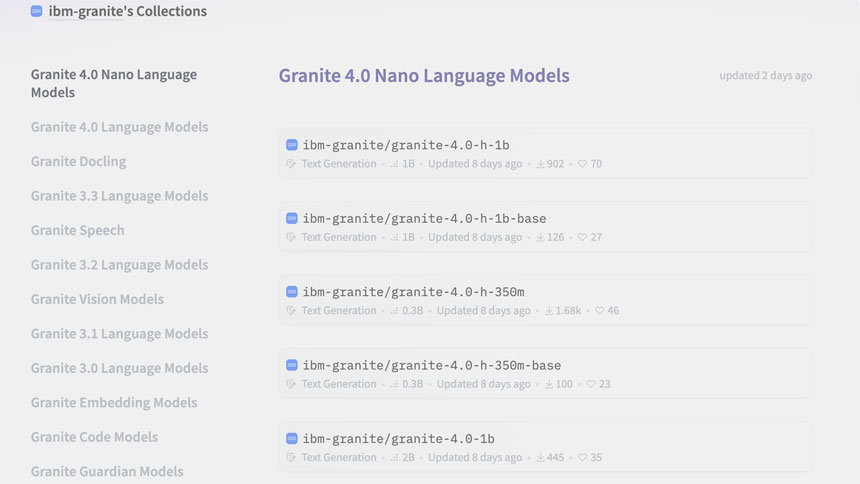

Esta familia de Granite 4.0 Nano incluye cuatro modelos de código abierto que ahora están disponibles en Hugging Face:

- Granite-4.0-H-1B (~1.5B parámetros) – Arquitectura híbrida SSM

- Granite-4.0-H-350M (~350M parámetros) – Arquitectura híbrida SSM

- Granite-4.0-1B – Variante basada en Transformer, con un conteo de parámetros cercano a 2B

- Granite-4.0-350M – Variante basada en Transformer

En general, el Granite-4.0-1B logró un puntaje de referencia promedio líder del 68.3% en dominios de conocimiento general, matemáticas, código y seguridad.

Para los desarrolladores e investigadores que buscan rendimiento sin sobrecarga, el lanzamiento de Nano significa que no necesitan 70 mil millones de parámetros para construir algo poderoso.