IBL News | Nueva York

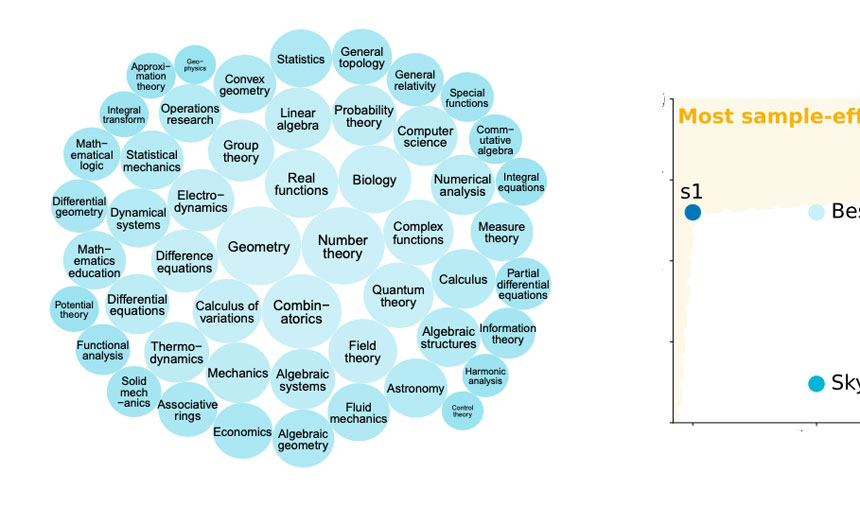

Los investigadores de Stanford y la Universidad de Washington afirmaron en un documento publicado este mes que lograron entrenar un modelo de razonamiento AI llamado s1, que tuvo un rendimiento similar al de o1 de OpenAI y R1 de DeepSeek en matemáticas y codificación.

El modelo s1, junto con los datos y el código, está disponible en GitHub. Según los investigadores, el costo de entrenamiento es de menos de $50 en créditos de computación en la nube.

Este equipo comenzó con un modelo base listo para usar y luego lo mejoró a través de la destilación, un proceso para extraer las capacidades de “razonamiento” de otro modelo de AI mediante el entrenamiento en sus respuestas.

El modelo fue destilado de Gemini 2.0 Flash Thinking Experimental, ofrecido de forma gratuita a través de la plataforma Google AI Studio.

La destilación es el mismo enfoque que los investigadores de Berkeley utilizaron para crear un modelo de razonamiento de AI por alrededor de $450 el mes pasado.

OpenAI ha acusado a DeepSeek de cosechar datos de manera inapropiada de su API para la destilación del modelo.

La destilación es un método adecuado para recrear de manera económica las capacidades de un modelo de AI, pero no crea nuevos modelos de AI.

El documento s1 sugirió que los modelos de razonamiento pueden ser destilados con un conjunto de datos relativamente pequeño utilizando el ajuste fino supervisado (SFT), en el cual se instruye explícitamente a un modelo de AI a imitar ciertos comportamientos en un conjunto de datos.

Más específicamente, s1 se basó en un modelo de AI pequeño y gratuito del laboratorio de AI chino propiedad de Alibaba, Qwen. Para entrenar s1, los investigadores crearon un conjunto de datos de solo 1,000 preguntas cuidadosamente seleccionadas emparejadas con respuestas a esas preguntas y el proceso de “pensamiento” detrás de cada respuesta del Gemini 2.0 Flash Thinking Experimental de Google.

Después de entrenar a s1, lo cual tomó menos de 30 minutos utilizando 16 GPU Nvidia H100, s1 logró un buen rendimiento en benchmarks específicos de AI.

Según el documento, los investigadores utilizaron un truco ingenioso para hacer que s1 verificara su trabajo y extendiera su tiempo de “pensamiento”: le dijeron que esperara. Agregar la palabra “esperar” durante el razonamiento de s1 ayudó al modelo a llegar a respuestas ligeramente más precisas.

Los expertos señalaron que s1 plantea preguntas fundamentales sobre la comercialización de los modelos de AI.